Случайная величина

Случайная величина — измеримая функция [math]\displaystyle{ y=\xi(\omega) }[/math], значения [math]\displaystyle{ y }[/math] которой численно выражают исходы [math]\displaystyle{ \omega }[/math] случайного эксперимента. Для обозначения случайной величины в математике принято использовать греческую букву «кси» [math]\displaystyle{ \xi }[/math]. Одним из требований к данной функции будет её измеримость, что служит для отсеивания тех случаев, когда значения данной функции [math]\displaystyle{ \xi(\omega) }[/math] бесконечно чувствительны к малейшим изменениям в исходах случайного эксперимента. Случайная величина как функция, отображает [math]\displaystyle{ \Omega }[/math] в множество действительных чисел [math]\displaystyle{ \mathbb{R} }[/math][1]. Если принять что [math]\displaystyle{ \lt \Omega,\mathfrak{F},P\gt }[/math] произвольное вероятностное пространство, то случайная величина [math]\displaystyle{ \xi }[/math] осуществляет измеримое отображение [math]\displaystyle{ \lt \Omega,\mathfrak{F}\gt }[/math] в [math]\displaystyle{ \lt \mathbb{R},\mathfrak{B}\gt }[/math]. Измиримость означает, что прообраз [math]\displaystyle{ \xi^{-1}(B)=\{\omega:\xi(\omega)\in{B}\} }[/math] любого борелевского множества [math]\displaystyle{ B\in\mathfrak{B} }[/math] есть множество из сигмы-алгебры [math]\displaystyle{ \mathfrak{F} }[/math].

Определяя случайную величину [math]\displaystyle{ \xi }[/math] мы отображаем множество всех исходов эксперимента (пространство элементарных событий) в новое пространство элементарных событий - множество действительных чисел. Например 36 исходов при бросании двух игральных костей [math]\displaystyle{ (1;1, 1;2, 2;1, 2;2 ... 6;6) }[/math] можно отобразить в 11 исходов суммы выпавших на костях очков [math]\displaystyle{ (2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12) }[/math]. (См.Пример Бросание костей). Таким образом, определяя случайную величину мы определяем новое пространство элементарных событий (значения случайной величины).

Как функция, случайная величина [math]\displaystyle{ \xi(\omega) }[/math] не является вероятностью наступления события [math]\displaystyle{ \omega }[/math], а возвращает численное выражение исхода [math]\displaystyle{ \omega }[/math]. Важными характеристиками случайных величин являются математическое ожидание и дисперсия[2].

На измеримом пространстве [math]\displaystyle{ \lt \mathbb{R},\mathfrak{B}\gt }[/math] в которое отображается множество исходов эксперимента [math]\displaystyle{ \lt \Omega,\mathfrak{F}\gt }[/math] определена вероятность [math]\displaystyle{ P_{\xi}(B)=P(\xi\in{B}) }[/math], которая порождает вероятностное пространство [math]\displaystyle{ \lt \mathbb{R},\mathfrak{B}, P_{\xi}\gt }[/math]. Функция вероятности для исходного пространства элементарных событий [math]\displaystyle{ \lt \Omega,\mathfrak{F}\gt }[/math] может быть использована для определения функции вероятности пространства элементарных событий порождаемых случайной величиной [math]\displaystyle{ \lt \mathbb{R},\mathfrak{B}\gt }[/math]. Вероятность [math]\displaystyle{ P_{\xi}(B) }[/math] называется распределением случайной величины [math]\displaystyle{ \xi }[/math] (См. Распределение случайной величины).

Случайную величину можно представить как переменную, значения которой представляют собой численные исходы некоторого случайного феномена или эксперимента. Другими словами, это численное выражение результата случайного события. Случайная величина является одним из основных понятий теории вероятностей.[3]

История

Роль случайной величины, как одного из основных понятий теории вероятностей, впервые была чётко осознана П. Л. Чебышёвым, который обосновал общепринятую на сегодня точку зрения на это понятие (1867)[4]. Понимание случайной величины как частного случая общего понятия функции, пришло значительно позднее, в первой трети 20 века. Впервые полное формализованное представление основ теории вероятностей на базе теории меры было разработано А. Н. Колмогоровым (1933)[5], после которого стало ясным, что случайная величина представляет собой измеримую функцию, определённую на вероятностном пространстве. В учебной литературе эта точка зрения впервые последовательно проведена У. Феллером (см. предисловие к[6], где изложение строится на основе понятия пространства элементарных событий и подчёркивается, что лишь в этом случае представление случайной величины становится содержательным).

Определение

Формальное математическое определение следующее: пусть [math]\displaystyle{ (\Omega,\mathcal{F}, \mathbb{P}) }[/math] — вероятностное пространство, тогда случайной величиной называется функция [math]\displaystyle{ \xi\colon\Omega \to \mathbb{R} }[/math], измеримая относительно [math]\displaystyle{ \mathcal{F} }[/math] и борелевской σ-алгебры на [math]\displaystyle{ \mathbb{R} }[/math].

Случайную величину можно определить и другим эквивалентным способом[7]. Функция [math]\displaystyle{ \xi\colon\Omega \to \mathbb{R} }[/math] называется случайной величиной, если для любых вещественных чисел [math]\displaystyle{ a }[/math] и [math]\displaystyle{ b }[/math] множество таких событий [math]\displaystyle{ \omega }[/math], что [math]\displaystyle{ \xi(\omega)\in(a,b) }[/math], принадлежит [math]\displaystyle{ \mathcal{F} }[/math].

Вероятностное поведение отдельной (независимой от других) случайной величины полностью описывается её распределением.

Способы задания

Задать случайную величину, описав этим все её вероятностные свойства как отдельной случайной величины, можно с помощью функции распределения, плотности вероятности и характеристической функции, определяя вероятности возможных её значений. Функция распределения [math]\displaystyle{ F(x) }[/math] равна вероятности того, что значение случайной величины меньше вещественного числа [math]\displaystyle{ x }[/math]. Из этого определения следует, что вероятность попадания значения случайной величины в интервал [a, b) равна [math]\displaystyle{ F(b)-F(a) }[/math]. Преимущество использования функции распределения заключается в том, что с её помощью удаётся достичь единообразного математического описания дискретных, непрерывных и дискретно-непрерывных случайных величин. Тем не менее, существуют разные случайные величины, имеющие одинаковые функции распределения. Например, если случайная величина [math]\displaystyle{ \xi }[/math] принимает значения +1 и −1 с одинаковой вероятностью 1/2, то случайные величины [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \xi^3 }[/math] описываются одной и той же функцией распределения F(x).

Другим способом задания случайной величины является функциональное преобразование случайной величины [math]\displaystyle{ \xi }[/math]. Если [math]\displaystyle{ f(x) }[/math] — борелевская функция, то [math]\displaystyle{ \eta=f(\xi) }[/math] также является случайной величиной. Например, если [math]\displaystyle{ \xi }[/math] — стандартная нормальная случайная величина, то случайная величина [math]\displaystyle{ \chi^2 = \xi^2 }[/math] имеет распределение хи-квадрат с одной степенью свободы. Многие распределения, в том числе распределение Фишера, распределение Стьюдента являются распределениями функциональных преобразований нормальных случайных величин.

Если случайная величина дискретная, то полное и однозначное математическое описание её распределения определяется указанием функции вероятностей [math]\displaystyle{ p_k=P(\xi=x_k) , \; k \in \mathbb{N} }[/math] всех возможных значений этой случайной величины. В качестве примера рассмотрим биномиальный и пуассоновский законы распределения.

Биноминальный закон распределения описывает случайные величины, значения которых определяют количество «успехов» и «неудач» при повторении опыта [math]\displaystyle{ N }[/math] раз. В каждом опыте «успех» может наступить с вероятностью [math]\displaystyle{ p }[/math], «неудача» — с вероятностью [math]\displaystyle{ q=1-p }[/math]. Закон распределения в этом случае определяется формулой Бернулли:

- [math]\displaystyle{ P_{k,n}=C_n^k\cdot p^k \cdot q^{n-k} }[/math].

Если при стремлении [math]\displaystyle{ n }[/math] к бесконечности произведение [math]\displaystyle{ np }[/math] остаётся равной константе [math]\displaystyle{ \lambda \gt 0 }[/math], то биномиальный закон распределения сходится к закону Пуассона, который описывается следующей формулой:

- [math]\displaystyle{ p(k) \equiv \mathbb{P}(Y=k) = \frac{\lambda^k}{k!}\, e^{-\lambda} }[/math],

где

- символ «[math]\displaystyle{ ! }[/math]» обозначает факториал,

- [math]\displaystyle{ e = 2.7182818284\ldots }[/math] — основание натурального логарифма.

Числовые характеристики случайных величин

Математическим ожиданием или средним значением случайной величины [math]\displaystyle{ \xi= \xi(\omega) }[/math] в линейном нормированном пространстве X на пространстве элементарных событий [math]\displaystyle{ (\Omega, \mathfrak{A}, \mathbb{P}) }[/math] называется интеграл

- [math]\displaystyle{ \mathop{\mathbb{E}}\xi =\int\limits_{\Omega}\xi(\omega)\, \mathbb{P}(d\omega)=\int\limits_{\Omega}x\mathbb{P_\xi}(d\omega) }[/math]

(в предположении, что функция [math]\displaystyle{ \xi= \xi(\omega) }[/math] является интегрируемой).

Дисперсией случайной величины [math]\displaystyle{ \xi }[/math] называется величина, равная:

- [math]\displaystyle{ \operatorname{D}\xi = \mathop{\mathbb{E}}(\xi - \mathop{\mathbb{E}}\xi)^2 = \mathop{\mathbb{E}}\xi^2 - (\mathop{\mathbb{E}}\xi)^2~. }[/math]

В статистике для дисперсии часто употребляется обозначение [math]\displaystyle{ \sigma_\xi^2 }[/math] или [math]\displaystyle{ \sigma^2 }[/math]. Величина [math]\displaystyle{ \sigma }[/math], равная

- [math]\displaystyle{ \sigma = \sqrt{\operatorname{D}\xi} }[/math]

называется среднеквадратическим отклонением, стандартным отклонением или стандартным разбросом.

Ковариацией случайных величин [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math] называется следующая величина:

- [math]\displaystyle{ \mathrm{cov}(\xi,\eta) }[/math] = [math]\displaystyle{ \operatorname{E}(\xi- \operatorname{E}{\xi})({\eta}- \operatorname{E}{\eta}) }[/math]

(предполагается, что математические ожидания определены).

Если [math]\displaystyle{ \mathrm{cov}(\xi,\eta) }[/math] = 0, то случайные величины [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math] называются не коррелированными. Независимые случайные величины всегда некоррелированы, однако обратное неверно[8].

Функция концентрации величины [math]\displaystyle{ \xi }[/math] называется функция [math]\displaystyle{ Q_F }[/math], заданная на неотрицательной полуоси следующим образом:

- [math]\displaystyle{ Q_F(x)=\sup_{t\in R}(F(t+x+0)-F(t)) }[/math].

Функции от случайных величин

Если [math]\displaystyle{ f(x) }[/math] — борелевская функция, а [math]\displaystyle{ \xi }[/math] — случайная величина, то ее функциональное преобразование [math]\displaystyle{ \eta=f(\xi) }[/math] также является случайной величиной. Например, если [math]\displaystyle{ \xi }[/math] — стандартная нормальная случайная величина, случайная величина [math]\displaystyle{ \chi^2 = \xi^2 }[/math] имеет распределение хи-квадрат с одной степенью свободы. Многие распределения, в том числе распределение Фишера и распределение Стьюдента, являются распределениями функциональных преобразований нормальных случайных величин.

Если [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math] с совместным распределением [math]\displaystyle{ F_{\xi\eta}(x, y) }[/math], а [math]\displaystyle{ \phi = \phi(x, y) }[/math] — некоторая борелевская функция, то для [math]\displaystyle{ \zeta = \phi(\xi, \eta) }[/math] справедливо[9]:

- [math]\displaystyle{ F_{\zeta}(z) = \int\limits_{\{x, y: \phi(x, y) \leqslant z\}} \, dF_{\xi\eta}(x, y)~. }[/math]

Если [math]\displaystyle{ \phi(x, y) = x+y }[/math], [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math] независимы, то [math]\displaystyle{ F_{\xi\eta}(x, y) = F_{\xi}(y) F_{\eta}(y) }[/math]. Применяя теорему Фубини, получаем:

- [math]\displaystyle{ F_{\zeta}(z) = \int\limits_{-\infty}^{\infty} \, F_{\eta}(z-x) dF_{\xi}(x) }[/math]

и аналогично:

- [math]\displaystyle{ F_{\zeta}(z) = \int\limits_{-\infty}^{\infty} \, F_{\xi}(z-y) dF_{\eta}(y)~. }[/math]

Если [math]\displaystyle{ F }[/math] и [math]\displaystyle{ G }[/math] функции распределения, то функцию

- [math]\displaystyle{ H(z) = \int\limits_{-\infty}^{\infty} \, F(z-x) dG(x) }[/math]

называют свёрткой [math]\displaystyle{ F }[/math] и [math]\displaystyle{ G }[/math] и обозначают [math]\displaystyle{ F*G }[/math].

Характеристическая функция [math]\displaystyle{ \zeta = \xi +\eta }[/math] суммы независимых случайных величин [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math] является преобразованием Фурье свёртки [math]\displaystyle{ F*G }[/math] функций распределения [math]\displaystyle{ F }[/math] и [math]\displaystyle{ G }[/math] и равна произведения характеристических функций [math]\displaystyle{ \xi }[/math] и [math]\displaystyle{ \eta }[/math]:

- [math]\displaystyle{ \phi_{\zeta}(u) = \phi_{\xi}(u)\phi_{\eta}(u)~. }[/math]

Применение и примеры

Примером объектов, для представления состояния которых требуется применение случайных величин, являются микроскопические объекты, описываемые квантовой механикой. Случайными величинами описываются события передачи наследственных признаков от родительских организмов к их потомкам (см. Законы Менделя). К случайным относятся события радиоактивного распада ядер атомов.[3]

Существует ряд задач математического анализа и теории чисел, для которых участвующие в их формулировках функции целесообразно рассматривать как случайные величины, определённые на подходящих вероятностных пространствах[10].

Дискретная и непрерывная случайные величины

Случайные величины делятся на дискретные случайные величины и непрерывные случайные величины.

От того является ли величина дискретной или непрерывной зависит, является ли функция распределения дискретной или непрерывной. Такая связь функции распределения и случайно величины дает возможность определить непрерывную случайную величина через функцию распределения.

Случайная величина [math]\displaystyle{ X }[/math] является непрерывной если функция распределения [math]\displaystyle{ P(x) }[/math] для [math]\displaystyle{ x }[/math] является непрерывной. Случайная величина [math]\displaystyle{ X }[/math] является дискретной если функция распределения [math]\displaystyle{ P(x) }[/math] для [math]\displaystyle{ x }[/math] является дискретной.

- Дискретные и непрерывные случайные величины

-

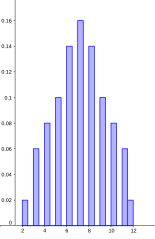

Пример дискретной случайной величины. Сумма выпавших двух игральных костей как в примере Бросание игральных костей

-

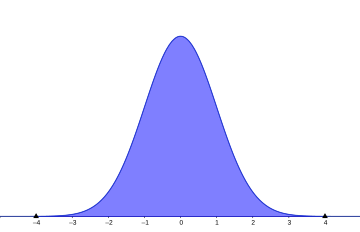

Пример непрерывной случайной величины. Температура воздуха в марте.

Дискретная случайная величина

Примерами дискретной случайной величины могут служить показания спидометра или измерения температуры в конкретные моменты времени[11].

Подбрасывание монеты

Все возможные исходы подбрасывания монеты могут быть описаны пространством элементарных событий [math]\displaystyle{ \Omega =\{ }[/math]орёл, решка[math]\displaystyle{ \} }[/math] или кратко [math]\displaystyle{ \{op,pe\} }[/math]. Пусть случайная величина [math]\displaystyle{ \xi }[/math] равна выигрышу в результате подбрасывания монеты. Пусть выигрыш будет 10 рублей каждый раз, когда монета выпадает орлом, и −33 рубля при выпадении решки. Математически эту функцию выигрыша можно представить так:

- [math]\displaystyle{ \xi(\omega) = \begin{cases} 10, & \text{если } \omega = \text{op},\\[6pt] -33, & \text{если } \omega = \text{pe}. \end{cases} }[/math]

Если монета идеальная, то выигрыш [math]\displaystyle{ \xi }[/math] будет иметь вероятность, заданную как:

- [math]\displaystyle{ P(\xi=y) = \begin{cases} \tfrac 12,& \text{если }y=10,\\[6pt] \tfrac 12,& \text{если }y=-33, \end{cases} }[/math]

- где [math]\displaystyle{ P(\xi=y) }[/math] — вероятность получения [math]\displaystyle{ y }[/math] рублей выигрыша при одном подбрасывании монеты.

Бросание игральных костей

Случайная величина также может быть использована для описания процесса бросания игральных костей, а также для расчёта вероятности конкретного исхода таких бросков. В одном из классических примеров данного эксперимента используются две игральные кости [math]\displaystyle{ n_1 }[/math] и [math]\displaystyle{ n_2 }[/math], каждая из которых может принимать значения из множества {1, 2, 3, 4, 5, 6} (количество очков на сторонах костей). Пространство элементарных событий для двух игральных костей состоит из [math]\displaystyle{ 6^2 }[/math], то есть [math]\displaystyle{ 36 }[/math] элементов: [math]\displaystyle{ (1;1, 1;2, 2;1, 2;2 ... 6;6) }[/math]. Однако нас не интересуют комбинации значений костей, но только общее количество очков. Общее количество очков выпавших на костях и будет значением нашей случайной величины [math]\displaystyle{ \xi }[/math], которая задаётся функцией:

- [math]\displaystyle{ \xi((n_1, n_2)) = n_1 + n_2 }[/math]

и (если кости идеальные) функция вероятности для [math]\displaystyle{ \xi }[/math] задаётся через:

- [math]\displaystyle{ P(S) = \frac{\min(S-1, 13-S)}{36}, \text{ for } S \in \{2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12\} }[/math],

- где [math]\displaystyle{ S }[/math] — сумма очков на выпавших костях.

Колода карт

Пусть экспериментатор тянет наугад одну из карт в колоде игральных карт. Тогда [math]\displaystyle{ \omega }[/math] будет представлять одну из вытянутых карт; здесь [math]\displaystyle{ \omega }[/math] не число, а карта — физический объект, название которого обозначается через символ [math]\displaystyle{ \omega }[/math]. Тогда функция [math]\displaystyle{ \xi(\omega) }[/math], принимая в качестве аргумента «название» объекта, вернёт число, с которым мы будем в дальнейшем ассоциировать карту [math]\displaystyle{ \omega }[/math]. Пусть в нашем случае экспериментатор вытянул Короля Треф, то есть [math]\displaystyle{ \omega =K_\clubsuit }[/math], тогда после подставления этого исхода в функцию [math]\displaystyle{ \xi(K_\clubsuit) }[/math], мы получим уже число, например, 13. Это число не является вероятностью вытягивания короля из колоды или любой другой карты. Это число является результатом перевода объекта из физического мира в объект математического мира, ведь с числом 13 уже можно проводить математические операции, в то время как с объектом [math]\displaystyle{ K_\clubsuit }[/math] эти операции проводить было нельзя.

Абсолютно непрерывная случайная величина

Другой класс случайных величин — такие, для которых существует неотрицательная функция [math]\displaystyle{ p(x) }[/math], удовлетворяющая при любых [math]\displaystyle{ x }[/math] равенству [math]\displaystyle{ P(\omega \mid \xi(\omega)\leq x) = \textstyle \int\limits_{-\infty}^{x} \displaystyle p(z)dz }[/math]. Случайные величины, удовлетворяющие этому свойству называются абсолютно непрерывными, а функция [math]\displaystyle{ p(x) }[/math] называется плотностью распределения вероятностей.

Число возможных значений абсолютно непрерывной случайной величины бесконечно. Пример абсолютно непрерывной случайной величины: измерение скорости перемещения любого вида транспорта или температуры в течение конкретного интервала времени.[11]

Рост случайного прохожего

Пусть в одном из экспериментов нужно случайным образом выбрать одного человека (обозначим его как [math]\displaystyle{ \omega }[/math]) из группы испытуемых, пусть тогда случайная величина [math]\displaystyle{ \xi }[/math] выражает рост выбранного нами человека. В этом случае, с математической точки зрения, случайная величина [math]\displaystyle{ \xi }[/math] интерпретируется как функция [math]\displaystyle{ y=\xi(\omega) }[/math], которая трансформирует каждого испытуемого [math]\displaystyle{ \omega }[/math] в число — его рост [math]\displaystyle{ y }[/math]. Для того чтобы рассчитать вероятность того, что рост человека попадёт в промежуток между 180 см и 190 см, или вероятность того, что его рост будет выше 150 см, нужно знать распределение вероятности [math]\displaystyle{ \xi }[/math], которое в совокупности с [math]\displaystyle{ \xi }[/math] и позволяет рассчитывать вероятности тех или иных исходов случайных экспериментов.

Простейшие обобщения

Случайная величина, вообще говоря, может принимать значения в любом измеримом пространстве. Тогда её чаще называют случайным вектором или случайным элементом. Например,

- Измеримая функция [math]\displaystyle{ \xi\colon\Omega \to \mathbb{R}^n }[/math] называется [math]\displaystyle{ n }[/math]-мерным случайным вектором (относительно борелевской [math]\displaystyle{ \sigma }[/math]-алгебры на [math]\displaystyle{ \mathbb{R}^n }[/math]).

- Измеримая функция [math]\displaystyle{ \xi\colon\Omega \to \mathbb{C}^n }[/math] называется [math]\displaystyle{ n }[/math]-мерным комплексным случайным вектором (также относительно соответствующей борелевской [math]\displaystyle{ \sigma }[/math]-алгебры).

- Измеримая функция, отображающая вероятностное пространство в пространство подмножеств некоторого (конечного) множества, называется (конечным) случайным множеством.

См. также

- Теория вероятностей

- Алгебра событий

- Случайное событие

- Пространство элементарных событий

- Вероятность

- Функция распределения

- Математическое ожидание

- Дисперсия случайной величины

- Закон больших чисел

- Центральная предельная теорема

- Случайный процесс

Примечания

- ↑ Чернова, 2007, с. 49—50.

- ↑ Случайная величина — статья из Большой советской энциклопедии.

- ↑ 3,0 3,1 Прохоров Ю. В. Случайная величина //Математическая энциклопедия/Под ред. Виноградова И. М.- М.: Советская энциклопедия, 1985.-Т.5.- Стр. 9.- 623 с.

- ↑ Чебышев П. Л., О средних величинах, в кн.: Полн. Собр. Соч., т. 2, М.- Л., 1947

- ↑ Колмогоров А. Н., Основные понятия теории вероятностей, 2 изд., М., 1974

- ↑ Феллер В., Введение в теорию вероятностей и её приложения, пер. с англ., 2 изд., т. 1, М., 1967

- ↑ Чернова Н. И. Глава 6. Случайные величины и их распределения § 1. Случайные величины // Теория вероятностей. — Учебное пособие. — Новосибирск: Новосибирский гос. ун-т, 2007. — 160 с.

- ↑ Joseph P. Romano, Andrew F. Siegel. Counterexamples in Probability and Statistics. — Belmont, California: Wadsworth, Inc., 1986. — 326 с. — ISBN 0534055680.

- ↑ Ширяев А. Н. Вероятность. — М:.: Наука. Гл. ред. физ.-мат. лит., 1989. — 640 с. — ISBN 5-02-013995-6.

- ↑ Кац М., Статистическая независимость в теории вероятностей, анализе и теории чисел, пер. с англ., М., 1963.

- ↑ 11,0 11,1 Образовательный портал ТГУ. edu.tltsu.ru. Дата обращения: 26 июня 2020.

Литература

- Гнеденко Б. В. Курс теории вероятности. — 8-е изд. доп. и испр. — М.: Едиториал УРСС, 2005. — 448 с. — ISBN 5-354-01091-8.

- Математический энциклопедический словарь / Гл. ред. Прохоров Ю. В.. — 2-е изд. — М.: «Советская энциклопедия», 1998. — 847 с.

- Тихонов В.И., Харисов В.Н. Статистический анализ и синтез радиотехнических устройств и систем. — Учебное пособие для ВУЗов. — М.: Радио и связь, 1991. — 608 с. — ISBN 5-256-00789-0.

- Чернова Н. И. Теория вероятностей. — Учебное пособие. — Новосибирск: Новосибирский гос. ун-т, 2007. — 160 с.